Während sich unzählige KI-Expert:innen und Autor:innen darauf gestürzt haben, OpenAIs neuestes Modell zu verstehen und zu erklären, habe ich den freien Kopf im Urlaub dafür genutzt, die darin verwendeten Ideen und Konzepte einen Schritt weiter zu denken und bin dabei auf einen spannenden Ansatz für bessere Modellbildung in LLMs gestoßen.Wenn über die Entwicklung von Large Language Models (LLMs) und ihren potenziellen Weg zu einer allgemeinen künstlichen Intelligenz (AGI) diskutiert wird, kommt häufig das Argument auf, dass diese Modelle keine echten Weltmodelle besitzen.

Wieso uns LLMs womöglich nicht zu allgemeiner künstlicher Intelligenz führen?

Es gibt Diskussionen darüber, ob LLMs nur durch das Training mit großen Mengen an Text (also unstrukturierte Daten) in der Lage sind, ein tiefes Verständnis der Welt zu entwickeln. Viele Forscher:innen zweifeln daran, dass dies ohne eine „Verankerung“ in der realen Welt möglich ist.

Der KI-Forscher Yann LeCun argumentiert, dass „World Models“ mehrere Ebenen der Abstraktion und Zeit umfassen sollten. Das bedeutet, dass diese Modelle nicht nur in der Lage sein sollten, aktuelle Situationen zu verstehen, sondern auch langfristig planen, zukünftige Ereignisse vorhersagen und auf Basis dieser Informationen logische Schlüsse ziehen.

Forscher:innen wie Liu et al. (2022) schlagen vor, LLMs in die physische Welt einzubetten, indem sie das Modell über Ergebnisse von Simulationen in der realen Welt nachdenken lassen. Das bedeutet, dass das Modell durch Simulationen lernt, wie die Welt funktioniert, um so sein internes Modell zu verbessern.

Kritiker bemängeln, dass LLMs lediglich Wahrscheinlichkeiten für Textvorhersagen berechnen und dadurch keine tiefere „Verständnisstruktur“ entwickeln können. Doch wie aktuelle Forschung und Experimente zeigen, ist diese Sichtweise zu eindimensional.

Doch Studien wie die von Hao et al. (2023) nutzen LLMs als „World Models“, indem sie das Modell dazu bringen, künftige Zustände vorherzusagen, basierend auf vordefinierten Handlungen und Aufgaben. Das Modell kann dann durch Simulationen erlernen, wie die Welt sich aufgrund von Aktionen verändert.

Mehrere Forschungen untersuchen, wie LLMs interne Repräsentationen der Welt bilden. Zum Beispiel zeigen Studien, dass LLMs durch „In-Context-Learning“ (wo sie aus dem Kontext eines gegebenen Problems lernen) Farb- und Raumstrukturen lernen können. Das bedeutet, dass sie in der Lage sind, abstrakte Informationen aus der realen Welt zu verstehen und zu nutzen.

Neuere Studien haben entdeckt, dass speziell trainierte LLMs „lineare Repräsentationen“ von Raum, Zeit und Spielzuständen entwickeln. Das ist besonders wichtig, weil diese Strukturen helfen, dynamische und kausale Zusammenhänge in der realen Welt zu verstehen – was eine Grundlage für fortgeschrittene Weltmodelle sein könnte.

Ein faszinierendes Beispiel aus dem Paper Sparks of Artificial General Intelligence zeigt, dass LLMs sehr wohl in der Lage sind, implizite Modelle aus ihren Trainingsdaten zu erstellen. So hat eine frühe Version von GPT-4 auf die Anfrage, ein Einhorn in der Vektorgrafik-Sprache TikZ zu zeichnen, überraschend präzise Ergebnisse geliefert – obwohl das Modell nie ein Bild eines Einhorns „gesehen“ hat. Es hat quasi selbst die Modalitäten überbrückt.

Im Paper sind drei anschauliche Beispiele hierfür enthalten:

Diese Fähigkeit zur impliziten Modellbildung legt aus meiner Sicht nahe, dass LLMs potenziell weit mehr leisten können, als nur Textbausteine zu generieren.

OpenAIs Strawberry-Modell: Ein Weg in die Zukunft?

Bisher konzentrierte sich der Fortschritt bei Large Language Models (LLMs) hauptsächlich auf sprachbasierte Aufgaben wie Textgenerierung und -bearbeitung. Doch mit dem neuen „o1“-Modell betritt OpenAI Neuland: Es ist speziell für mehrstufige Reasoning-Aufgaben ausgelegt und zeigt beeindruckende Fortschritte in Bereichen wie Mathematik, Codierung und Wissenschaft. Im Gegensatz zu früheren Modellen nutzt o1 eine Art Chain-of-Thought-Technik, die es dem Modell ermöglicht, Fehler zu erkennen und alternative Lösungswege auszuprobieren.

In Tests erzielte o1 herausragende Ergebnisse: Es gehört zu den besten 500 Teilnehmern der USA Math Olympiad und übertrifft in PhD-Fragen sogar menschliche Experten. Dies ist ein wichtiger Schritt, da LLMs bisher häufig an komplexen, logischen Fragestellungen scheiterten. Auch wenn das Modell kostenintensiv ist und nicht für alle Aufgaben geeignet, markiert es den Beginn einer Ära, in der LLMs echten Mehrwert für anspruchsvolle wissenschaftliche und technische Aufgaben liefern können.

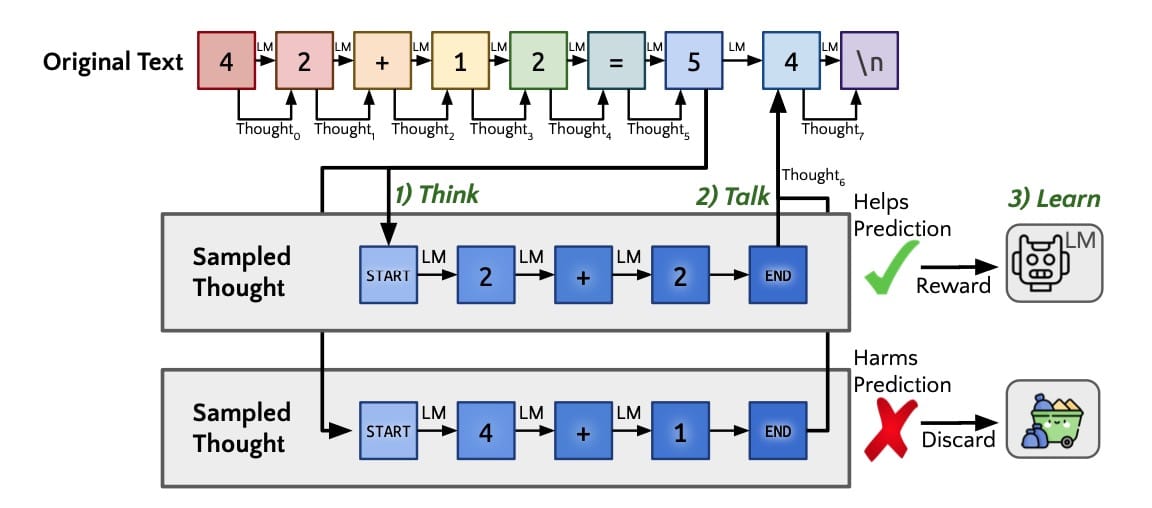

Nach allem, was derzeit bekannt ist, verfügt das Modell offenbar über einen internen, impliziten Tree-of-Thought-Mechanismus, der es ermöglicht, vor der Antwortverarbeitung verschiedene mögliche Gedankengänge durchzuspielen. Ähnlich wie beim menschlichen Denken werden dabei potenzielle Lösungswege verzweigt und in einem Baum strukturiert. Diese Fähigkeit wird über ein eigenes Reward-Modell optimiert, das die „Gedankengänge“ in Bezug auf ihre Relevanz und Korrektheit bewertet und verstärkt.

Dieser Ansatz, der auf den bereits existierenden Chain-of-Thought- und Tree-Of-Thought-Prompts basiert, zeigt eindrucksvoll, wie LLMs über die bloße Textvorhersage hinauswachsen können: Sie „denken“ nun vor einer Antwort über das Problem nach, indem sie alternative Lösungswege simulieren und dann die beste Option wählen. Damit sind sie deutlich näher an einer Form von bewusster Problemlösung, als es zuvor der Fall war.

Forced-Model: Ein realistischer Ansatz?

Genau diese Idee des Tree-of-Thought-Mechanismus könnte der Schlüssel sein, um das Problem fehlender expliziter Weltmodelle bei LLMs zu lösen. Was wäre, wenn wir diesen Mechanismus nutzen, um LLMs zu „zwingen“, vor der Lösung komplexer Aufgaben zunächst ein Modell der Situation, also eine Art „Forced-Model“ zu erstellen?

Ich stelle mir das ähnlich wie beim Tree-of-Thought vor, nur dass das Modell hier zunächst eine serialisierte Repäsentation erstellt, die als eine Art mentales Model genutzt wird, um dieses Schritt für Schritt zu einer universalen Repräsentation der gegebenen Umgebung oder Aufgabe vervollständigt, die es dann zur Lösung nutzt.

Ein Beispiel:

Derzeitige LLMs scheitern beispielsweise an üblichen Intelligenztest, bei dem das Modell zunächst eine Reihe von Beschreibungen zu einem Gebäude erhält und anschließend Fragen dazu beantworten soll.

Zwar sind sie in der Lage, einen potentiellen Dieb dabei in den falschen Raum zu schicken, damit dieser den Tresor nicht findet, schaffen es aber nicht, die beschriebenen Räume so zu organisieren, dass es den kürzesten Weg von Raum X nach Raum Y finden kann.

Was wenn wir es, analog zum Tree-Of-Thought, zunächst dazu zwingen, ein Modell des Gebäudes zu erstellen?

Wenn das LLM mit einer detaillierten Raumbeschreibung konfrontiert wird, könnte es angewiesen werden, zunächst eine interne Struktur (zum Beispiel in Form eines JSON-Objekts oder eines Graphen) zu erstellen, in der die Räume und ihre Verbindungen erfasst werden.

Dieses Modell könnte dann verwendet werden, um Fragen zu beantworten, wie etwa den kürzesten Weg von Raum A nach Raum B zu finden. Analog zum Tree-of-Thought in OpenAIs Strawberry könnte auch dieser Modellbildungsansatz über ein Reward-Modell optimiert werden, um genauere und effizientere Modellstrukturen zu fördern.

Mögliche Implementierungen

Natürlich stehen wir dabei vor der Frage, welche Art von Repräsentation sich für solch ein internes Modell am besten eignet. Für räumliche Strukturen könnten Graphen gut geeignet sein, während für andere Aufgaben, wie logische Schlussfolgerungen oder Entscheidungsbäume, JSON oder XML als flexible und universelle Datenformate in Frage kommen.

Die Herausforderung besteht darin, eine universelle Repräsentation zu finden, die auf eine Vielzahl von Aufgaben angewendet werden kann.

Verknüpfung symbolischer KI mit Sprachmodellen?

Die Lösung könnte in der Kombination von neuronalen Netzen und Techniken der symbolischen Künstlichen Intelligenz liegen. Durch diese Integration können wir beide Welten vereinen: die Flexibilität und Mustererkennung der neuronalen Modelle und das präzise, regelbasierte Denken der symbolischen KI.

Wissensgraphen und Ontologien: Strukturierte Repräsentation

Wissensgraphen und Ontologien sind leistungsstarke Werkzeuge, um Entitäten und deren Beziehungen zueinander zu organisieren. Die Idee ist simpel: Das Sprachmodell extrahiert aus einem Text relevante Informationen und formt daraus einen Graphen. Dies ermöglicht es, Wissen explizit darzustellen und zu erweitern – sei es durch Verknüpfungen mit externen Wissensdatenbanken oder durch eigene Schlussfolgerungen.

So könnte beispielsweise ein Gebäudebeschreibungsmodell Räume als Knoten und Türen oder Flure als Verbindungen darstellen. Besonders in komplexen Abfragen oder Planungsaufgaben zeigt sich der Vorteil: Die KI kann logische Schlüsse ziehen und fundierte Antworten liefern. Allerdings ist fraglich, ob diese Art der Repräsentation für alle Szenarien geeignet ist.

Semantisches Parsen: Von Text zu Logik

Semantisches Parsen geht noch einen Schritt weiter. Hier wird natürliche Sprache in formale logische Repräsentationen übersetzt, die von symbolischen Reasonern verarbeitet werden können. Nehmen wir das Beispiel: „Der Konferenzraum befindet sich neben dem Empfangsbereich.“ Ein semantisch parsierendes System würde daraus eine logische Aussage formulieren: Neben(Konferenzraum, Empfangsbereich). Diese präzise Darstellung ermöglicht es, komplexe Fragen zu beantworten oder Zusammenhänge logisch zu erklären.

Optimierungsprobleme und Constraint Satisfaction

Die Modellierung von Problemen als Constraint Satisfaction Problems (CSP) könnte die Möglichkeiten der Sprachmodelle zusätzlich erweitern. Aufgabe ist es dabei, einen Zustand (d. h. Belegungen von Variablen) zu finden, der alle aufgestellten Bedingungen (Constraints) erfüllt.

Eine KI, die diese Technik nutzt, kann beispielsweise den optimalen Weg durch ein Gebäude unter Berücksichtigung aller Verbindungen und Hindernisse berechnen. Solche Optimierungsaufgaben sind vor allem in der Robotik oder bei Navigationslösungen von unschätzbarem Wert.

Die Herausforderung hierbei ist es jedoch, die ursprüngliche Aufgabenstellung in ein CSP zu transformieren und die Funktionen, Variablen und Bedingungen korrekt aufzustellen.

Logikprogrammierung: Fakten, Regeln und Schlussfolgerungen

Logikprogrammierung, etwa mit Prolog, könnte Sprachmodellen die Möglichkeit eröffnet, durch logische Regeln und Fakten Antworten zu finden. Das Modell erstellt auf Basis eines Prompts ein Programm, das durch symbolische Reasoner ausgeführt wird.

Ein Programm in Prolog ist eine Menge von Fakten und Regeln. Die Anwendung eines Programms besteht in der Beantwortung von Fragen. Antworten sind entweder nur Ja/Nein oder bestehen darin, dass Platzhalter (Variable) der Frage mit einem möglichen Inhalt belegt werden. Prolog-Programme können somit als logische Aussage interpretiert werden und beschreiben einen programmierten Ablauf des Interpreters.

In einem Gebäude-Szenario könnten Fakten wie „adjacent(a, b)“ und „adjacent(b, c)“ verwendet werden, um den besten Weg von Raum A zu Raum C zu berechnen.

Herausforderungen

Natürlich gibt es auch Herausforderungen bei der Integration symbolischer Techniken. Die Ambiguität der natürlichen Sprache ist eine davon. Hier können Disambiguierungstechniken und Rückfragen helfen. Ebenso stellt die Skalierbarkeit neuronaler und symbolischer Systeme ein Problem dar, das jedoch durch clevere Optimierungen, Heuristiken und Approximationsmethoden überwunden werden kann.

Die Verschmelzung symbolischer KI mit neuronalen Modellen könnte den entscheidenden Schritt in Richtung Artificial General Intelligence (AGI) sein. Die Fähigkeit, nicht nur Texte zu verarbeiten, sondern auch logische Schlüsse zu ziehen, eröffnet neue Möglichkeiten in der Robotik, bei Entscheidungsunterstützungssystemen und in kognitiven Anwendungen.

Ein weiteres Problem ist die Kontextgröße. Je größer und komplexer das erstellte Modell wird, desto mehr Daten muss das LLM gleichzeitig verarbeiten. Hier könnten Ansätze wie externe Speichermodule oder Memory-Management-Techniken helfen, um die Leistungsfähigkeit zu erhalten.

Auf dem Weg zur AGI?

Die neural-symbolische Integration kombiniert die Stärken neuronaler Netze und symbolischer Systeme, was besonders interessant ist, um Modelle interpretierbarer und nachvollziehbarer zu machen. Ein Sprachmodell könnte zunächst die Informationen extrahieren und in einer symbolischen Repräsentation organisieren, bevor es durch logische Schlüsse zur gewünschten Antwort gelangt. Diese wird dann in natürliche Sprache zurückübersetzt. Das Ergebnis? Modelle, die nicht nur Wahrscheinlichkeiten manipulieren, sondern logisch denken können.

Auch wenn LLMs noch nicht die ultimative Lösung für eine echte allgemeine Intelligenz darstellen, könnten Ansätze wie „Strawberry“ und die Idee eines Forced-Model-Mechanismus in die richtige Richtung führen.

LLMs könnten bald in der Lage sein, nicht nur logisch zu denken, sondern auch strukturelle Modelle zu entwickeln, die ihnen helfen, komplexe Aufgaben besser zu bewältigen. Die Frage ist nicht mehr, ob LLMs Weltmodelle entwickeln können, sondern wie wir sie dazu bringen, diese Modelle effizient zu erstellen und anschließend gezielt zu nutzen.

Die Diskussion über diese neuen Ansätze ist eröffnet – wer hat Ideen, wie eine universelle Repräsentation für solche Modelle aussehen könnte?

Update: Forced-Model: Neue Erkenntnisse durch den Ansatz der „Visualization-of-Thought“

Nachdem ich das Konzept des „Forced-Model“ entwickelt habe, das LLMs zwingt, vor der Lösung komplexer Aufgaben ein internes Modell zu erstellen, hat sich ein neues Paper aus der Forschung als besonders relevant erwiesen: „Mind’s Eye of LLMs: Visualization-of-Thought Elicits Spatial Reasoning in Large Language Models“ von Wenshan Wu et al. Dieses Paper stellt einen vielversprechenden Ansatz vor, der mein ursprüngliches Konzept entscheidend erweitern könnte.

„Mind’s Eye“ und der Visualization-of-Thought-Ansatz

Das Paper führt den „Visualization-of-Thought“ (VoT)-Mechanismus ein, der darauf abzielt, LLMs zur Erzeugung visueller Darstellungen ihrer Denkprozesse anzuregen. Während herkömmliche LLMs bei der Bearbeitung von Aufgaben wie Navigation oder räumlichem Denken stark auf verbale oder numerische Repräsentationen angewiesen sind, fordert VoT das Modell auf, explizite mentale Bilder zu erzeugen. Diese Visualisierungen, ähnlich einem „inneren Auge“ des Modells, unterstützen das LLM dabei, sich bei jeder Phase einer komplexen Aufgabe an räumlichen Strukturen zu orientieren und bessere Entscheidungen zu treffen.

Interessanterweise ähnelt der VoT-Ansatz meinem Forced-Model-Konzept, bei dem ich vorschlage, dass LLMs gezwungen werden sollten, ein internes Modell einer gegebenen Umgebung zu erstellen, um Probleme Schritt für Schritt besser zu lösen. Doch VoT geht darüber hinaus, indem es das Modell dazu anleitet, seine mentalen Modelle in visuelle Darstellungen umzuwandeln. Dieser visuelle Ansatz könnte nicht nur zur Lösung von Navigationsproblemen beitragen, sondern auch bei der Bearbeitung anderer Aufgaben wie räumlicher Planung und logischer Schlussfolgerungen nützlich sein.

Erweiterung meines Forced-Model-Konzepts

Der VoT-Ansatz bietet eine wertvolle Erweiterung meines ursprünglichen Gedankens. Während ich ein Modell favorisiere, das auf symbolischen Darstellungen wie Graphen oder JSON-Objekten basiert, zeigt das Paper, dass visuelle Darstellungen die kognitiven Fähigkeiten der LLMs erheblich steigern können. In meinen bisherigen Überlegungen ging es hauptsächlich darum, LLMs zu zwingen, eine serialisierte und symbolische Repräsentation zu erstellen, bevor sie die Aufgabe angehen. Der VoT-Ansatz legt jedoch nahe, dass LLMs durch die visuelle Darstellung ihrer „Gedanken“ ein klareres Verständnis komplexer Aufgaben entwickeln können.

Das Potenzial der Visualisierung in LLMs

Die Forscher_innen stellten fest, dass der VoT-Ansatz insbesondere bei räumlichen Aufgaben wie der Navigation in einem 2D-Gitter oder der Lösung von visuellen Puzzles, bei denen geometrische Figuren in eine vorgegebene Struktur eingefügt werden müssen, signifikante Verbesserungen brachte. Diese Aufgaben lassen sich gut mit meinem Beispiel zur Navigation in einem Gebäude vergleichen. Indem das Forced-Model dazu gebracht wird, das Gebäude visuell zu modellieren, anstatt es nur symbolisch zu erfassen, könnte das Modell effizienter und genauer den kürzesten Weg von Raum A nach Raum B finden.

Integration von Visualisierung und symbolischer KI

Eine wichtige Erkenntnis aus dem Paper ist die Möglichkeit, visuelle und symbolische KI zu kombinieren. Mein ursprünglicher Vorschlag war, Techniken der symbolischen KI mit neuronalen Netzen zu kombinieren, um die Präzision und Logik von symbolischen Systemen mit der Flexibilität neuronaler Netze zu verbinden.

Das Paper schlägt jedoch vor, dass die visuelle Darstellung von Gedanken eine weitere wichtige Komponente in dieser Kombination sein könnte. Die Erzeugung und Nutzung von mentalen Bildern könnte symbolische und visuelle Repräsentationen eng miteinander verknüpfen, was zu einer weitaus stärkeren kognitiven Leistung führt.

Implementierung und Herausforderungen

Der VoT-Ansatz könnte direkt in mein Forced-Model-Konzept integriert werden, indem das Modell dazu angehalten wird, nach jeder Denkoperation visuelle Darstellungen seiner internen Zustände zu erstellen. Diese Darstellungen könnten in Form von Graphen, Karten oder anderen visuellen Modellen erfolgen und würden die symbolische Modellierung ergänzen. Besonders interessant ist die Möglichkeit, diese Visualisierungen durch ein Belohnungsmodell zu optimieren, um präzisere und effizientere Darstellungen zu fördern – ein Vorschlag, den ich bereits für die symbolischen Repräsentationen gemacht habe.

Es gibt jedoch auch Herausforderungen, wie im Paper beschrieben. Zum einen ist die Genauigkeit der Visualisierungen noch nicht perfekt. Auch bei der Nutzung des VoT-Ansatzes können fehlerhafte oder ungenaue Darstellungen entstehen, was die Gesamtleistung des Modells beeinträchtigt. Darüber hinaus könnte die Integration von symbolischen und visuellen Repräsentationen skalierbare Lösungen erfordern, um die kognitive Belastung des Modells zu minimieren.

Fazit: Auf dem Weg zur Artificial General Intelligence (AGI)

Die Erkenntnisse aus dem „Mind’s Eye of LLMs“-Paper bieten neue Impulse für die Weiterentwicklung des Forced-Model-Konzepts. Die Kombination aus symbolischer und visueller Modellbildung könnte der Schlüssel sein, um den nächsten Schritt in Richtung Artificial General Intelligence (AGI) zu gehen.

Indem LLMs nicht nur gezwungen werden, komplexe Probleme zu modellieren, sondern diese Modelle auch visuell zu nutzen, könnte ein neues Maß an kognitiver Flexibilität erreicht werden – besonders in Bereichen wie Robotik, Entscheidungsunterstützungssystemen und kognitiven Anwendungen.

Abonniere das kostenlose KI-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen aus den Bereichen Künstliche Intelligenz für dein Online Business, WordPress, SEO, Online-Marketing und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.