Im Zeitalter der künstlichen Intelligenz (KI) stehen wir an der Schwelle zu Entwicklungen, die das Potenzial haben, unser Verständnis von Technologie und Interaktion grundlegend zu verändern. Doch was geschieht, wenn die Grundlagen dieser revolutionären KI-Systeme in Frage gestellt werden? Ein spannendes Projekt namens „Knowing Machines“, initiiert von Christo Buschek und Jer Thorp, wirft ein kritisches Licht auf die Fundamente der generativen KI: Die Datensätze, auf denen diese Modelle trainiert werden.

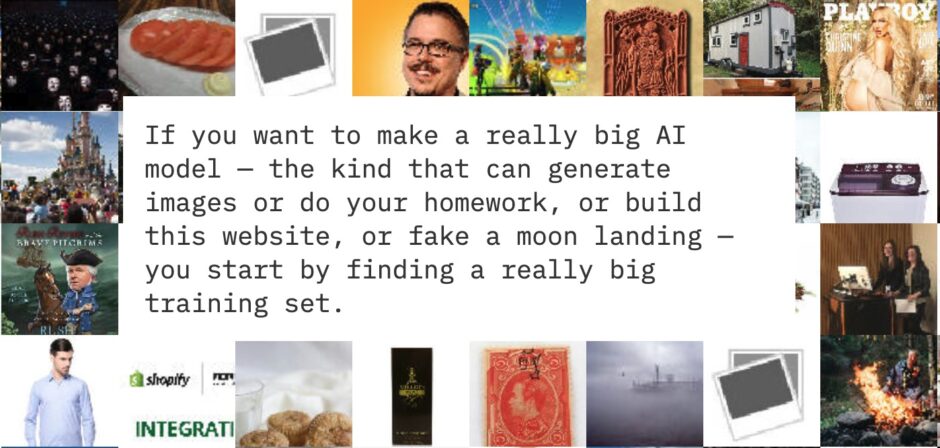

Die neueste visuelle Story „Models all the Way“ wirft einen Blick auf LAION-5B, einen Open-Source-Datensatz, der zum Trainieren von KI-Modellen wie Stable Diffusion verwendet wird. Er enthält 5,8 Milliarden Bild- und Textpaare – eine zu große Menge, um die Inhalte der Bilder zu verstehen. Mit einer großartigen visuellen Aufbereitung verfolgen die beiden den Aufbau des Datensatzes, um seinen Inhalt, seine Auswirkungen und seine Verstrickungen besser zu verstehen.

Die Faszination großer KI-Modelle, die Bilder generieren, Hausaufgaben erledigen oder sogar Mondlandungen fälschen können, beginnt mit einem immensen Trainingsset. Milliarden von Bildern und Texten, gesammelt aus dem Internet, dienen als Baumaterial für die Welt, die durch die KI widergespiegelt wird. Die Zusammensetzung dieser Trainingssets ist von entscheidender Bedeutung, da sie maßgeblich beeinflusst, was ein Modell leisten kann und wie gut es dies tut. Dennoch haben nur wenige Menschen die Inhalte dieser Sets, die ihre Modelle speisen, gründlich untersucht. Wenn sie es tun, treten oft ernsthafte Probleme zutage, nicht selten mit schwerwiegenden rechtlichen Konsequenzen.

Ein beunruhigendes Beispiel lieferte eine Untersuchung der Stanford’s Internet Observatory, die mehr als 3.000 Bilder als Material für sexuellen Missbrauch von Kindern (CSAM) in einem der einflussreichsten KI-Trainingssets der heutigen Zeit identifizierte: LAION-5B. Entworfen als offene Datenquelle von der deutschen Non-Profit-Organisation LAION, zielte dieses Projekt darauf ab, ein umfassendes Abbild der Welt zu erschaffen und damit eine Art Wörterbuch aus Dingen und Konzepten für KI-Modelle bereitzustellen. Doch die Entdeckung von CSAM-Bildern in LAION-5B, so alarmierend sie auch sein mag, überrascht kaum angesichts der schieren Größe des Datensatzes und der daraus resultierenden Unmöglichkeit einer manuellen Überprüfung.

Wie untersucht man also ein Trainingsset, dessen Durchsicht mehrere Leben in Anspruch nehmen würde?

Der Schlüssel liegt darin, genau zu verstehen, wie es erstellt wurde: LAION-5B basiert auf einem noch größeren Datensatz von Common Crawl und enthält Daten von mehr als 3 Milliarden Websites. Hierin wurde schlicht nach eingebundenen Bildern samt deren ALT-Attributen gesucht und diese in einen Datensatz überführt.

Die Idee ist gut, denn der eigentlich Zweck des ALT-Attributs ist es, die Zugänglichkeit zu verbessern, insbesondere für sehbehinderte Nutzer, die Bildschirmlesegeräte verwenden. Doch in der Realität haben weniger als 40 % der Bilder im Internet haben ALT-Tags. Bei einigen Websites ist der Anteil jedoch viel höher.

SlidePlayer zum Beispiel scheint ALT-Tags automatisch hinzuzufügen, indem er sie mit Text aus den PowerPoint-Folien füllt, die er aufnimmt. Pinterest generiert die Bildunterschriften auf seinen Seiten aus den ALT-Tags, so dass die Nutzer/innen gelernt haben, sie zu schreiben, bevor sie ihre Bilder „anpinnen“. Shopify-Nutzer/innen haben oft einen hohen Google PageRank im Auge und schreiben ALT-Tag-Beschreibungen mit Blick auf die Suchmaschinenoptimierung (SEO).

All das bedeutet, dass ALT-Tags nur sehr selten die Beschreibung des Bildinhalts enthält, sondern vielmehr Artefakte der Funktionsweise des Internets und der Ambitionen der Ersteller*innen, insbesondere im Einzelhandel abbilden.

Der Inhalt eines ALT-Tags sollte beschreiben, was auf dem Bild zu sehen ist. Meistens beschreiben ALT-Tags jedoch, was Algorithmen sehen sollen, und nicht, was die Menschen sehen sollen.

Doch auch die Art und Weise, wie diese Daten kuratiert werden, beeinflusst entscheidend, welche Bilder und Texte in den Datensatz aufgenommen werden: Ein zentrales Element bei der Erstellung von LAION-5B war die Verwendung des CLIP-Modells (Contrastive Language–Image Pre-training) von OpenAI, um zu bewerten, wie gut ein Text zu einem Bild passt. Dieser Ansatz offenbart, wie sehr die Inhalte von LAION-5B nicht nur von menschlichen Sichtweisen, sondern auch von den Mechanismen des Internets und kommerziellen Logiken geprägt sind.

Die Sprachverteilung innerhalb von LAION-5B wirft ebenfalls Fragen auf, insbesondere die überrepräsentation des Englischen im Vergleich zu anderen Sprachen. Dies spiegelt eine kulturelle Schieflage wider, die in die trainierten KI-Modelle übergeht und damit eine englischsprachige Perspektive über andere kulturelle und sprachliche Sichtweisen stellt. Darüber hinaus weist die kuratorische Praxis von LAION auf ein grundlegendes Problem hin: die Abhängigkeit von numerischen Schwellenwerten, die oft schlecht verstanden werden und die Konstruktion von Trainingssets tiefgreifend beeinflussen können.

Ein weiterer kritischer Punkt ist die Ästhetik innerhalb der generativen KI. Sets wie LAION-Aesthetics, die darauf abzielen, Bilder von „hoher visueller Qualität“ zu enthalten, offenbaren, wie sehr die Konzepte von visueller Anziehungskraft durch die Vorlieben einer sehr kleinen Gruppe von Individuen und die von Datensatzschöpfern gewählten Prozesse beeinflusst werden können.

Mein Fazit

Die Diskussionen über Eigentum und Sicherheit, die generative KI-Modelle ausgelöst haben, finden ihren Ursprung in Trainingssets wie LAION-5B. Doch die statistische Herangehensweise dieser Sets an solche Themen wirft die Frage auf, ob die Verantwortung für die Auswirkungen der KI nicht zu sehr auf zukünftige Akteure abgewälzt wird. Die Öffentlichkeit von Datensätzen, wie es LAION praktiziert, ist grundsätzlich ein wichtiger und begrüßenswerter Schritt in Richtung Transparenz und Verantwortlichkeit, doch die Herausforderungen, die durch die statistische Kuratierung und die inhärenten strukturellen Voreingenommenheiten entstehen, bleiben bestehen.

In einer Welt, in der KI-Systeme zunehmend unser Leben prägen, ist die Untersuchung von Trainingssets ein entscheidendes Instrument, um Einblick und Verständnis in die komplexesten Systeme zu gewinnen, die je vom Menschen konzipiert wurden. Die Forderung nach Transparenz bei Datensätzen ist daher von größter Bedeutung, wenn KI-Systeme jemals für ihre Auswirkungen in der Welt zur Rechenschaft gezogen werden sollen.

Abonniere das kostenlose KI-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen aus den Bereichen Künstliche Intelligenz für dein Online Business, WordPress, SEO, Online-Marketing und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.