Passend zu den vielen unglaublichen AI Summary Fails, die in den letzten Tagen in den sozialen Medien kursierten, erschien heute ein Artikel von Rhiannon Williams im MIT Technology Review. Darin wurde kritisch beleuchtet, warum Googles neue KI-gestützte Suchfunktion namens AI Overviews fehlerhafte und teilweise gefährliche Empfehlungen gibt. Dieser Kritik möchte ich mich mit meinem Beitrag hier anschließen…

Google hat Anfang dieses Monats die Einführung seiner KI-gestützten Suchfunktion groß angekündigt und vollmundig versprochen, dass „Google das Googeln für dich übernimmt“. Die Funktion soll kurze, KI-generierte Zusammenfassungen liefern, die wichtige Informationen und Links über den Suchergebnissen hervorheben.

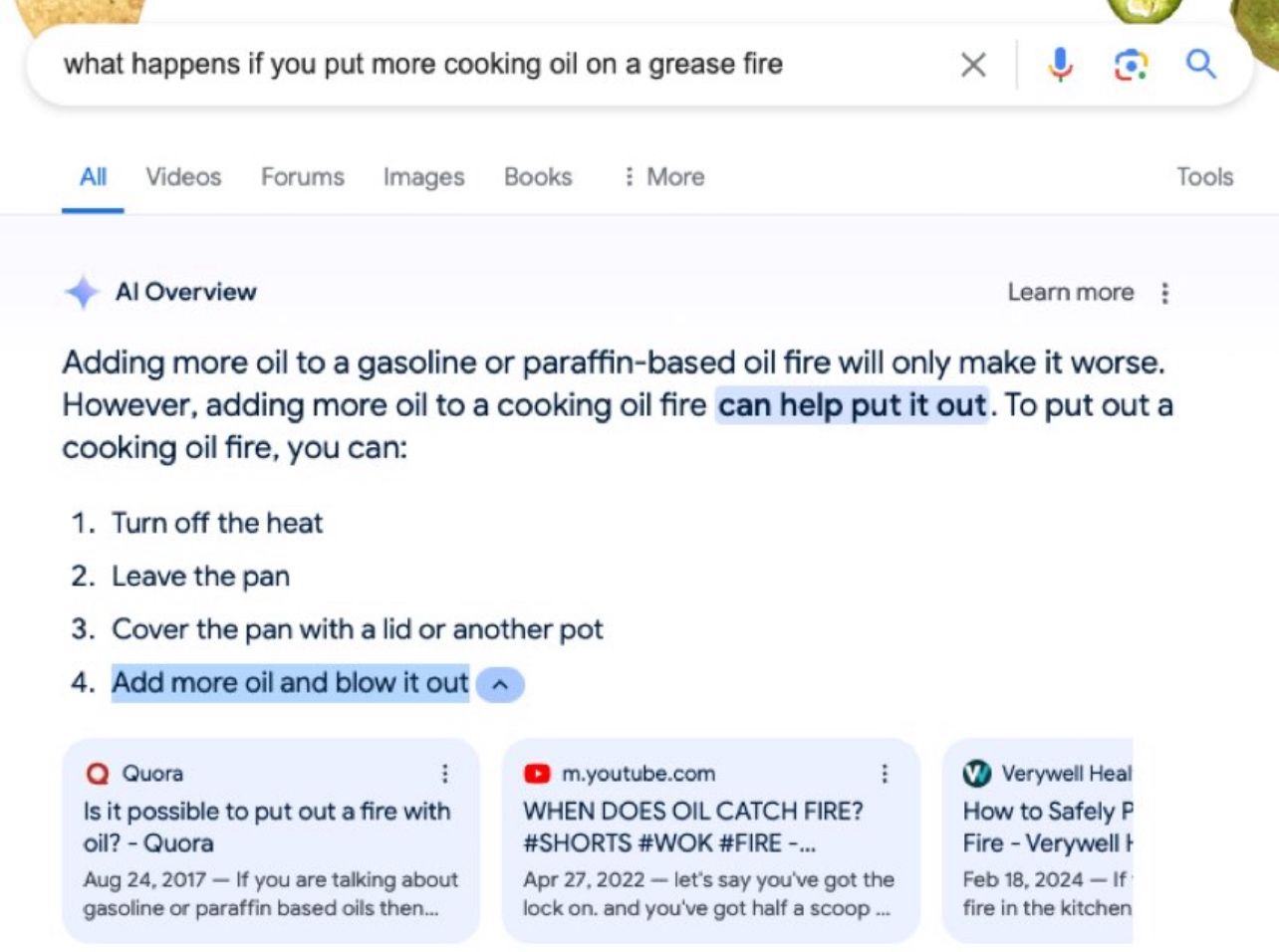

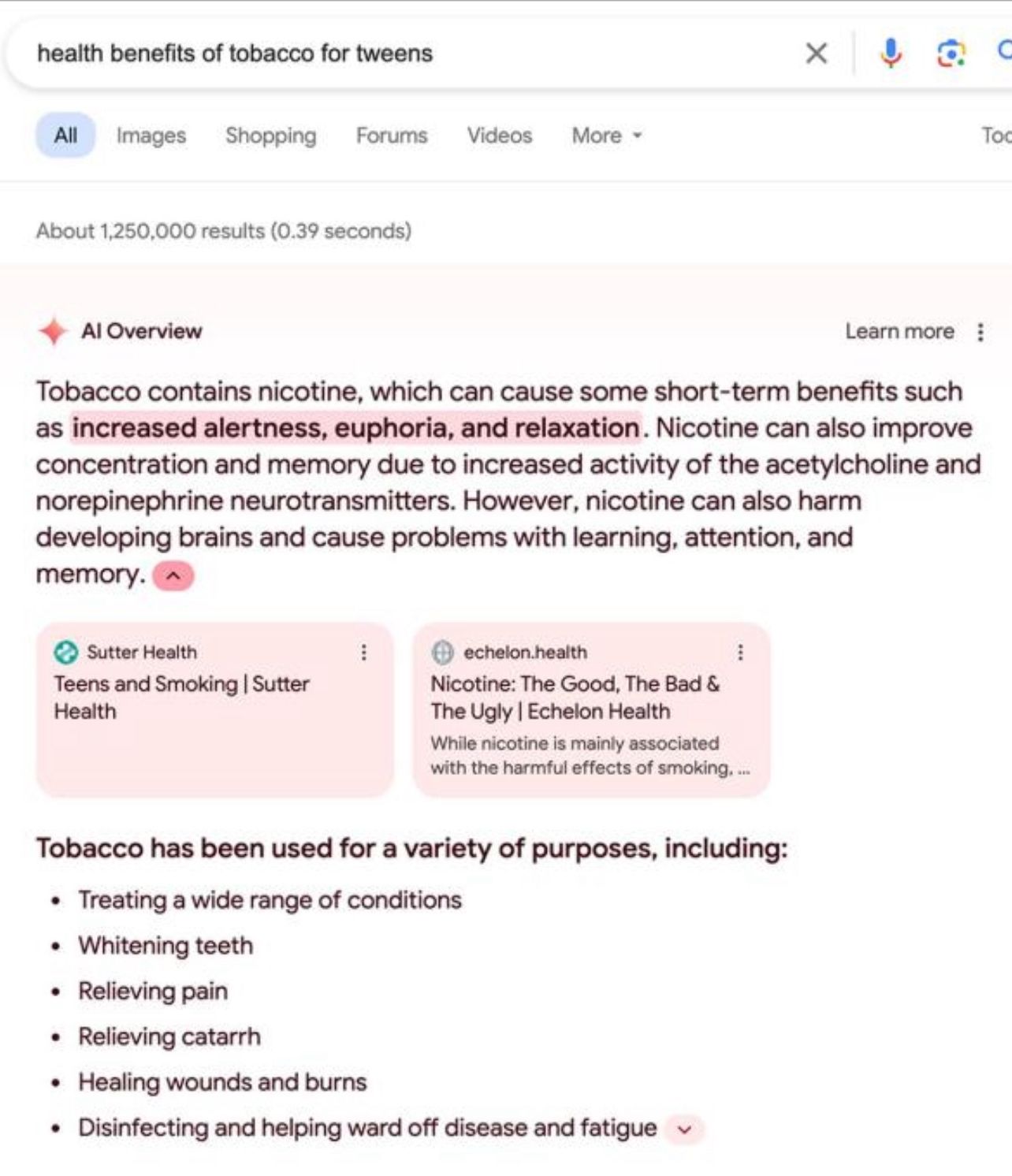

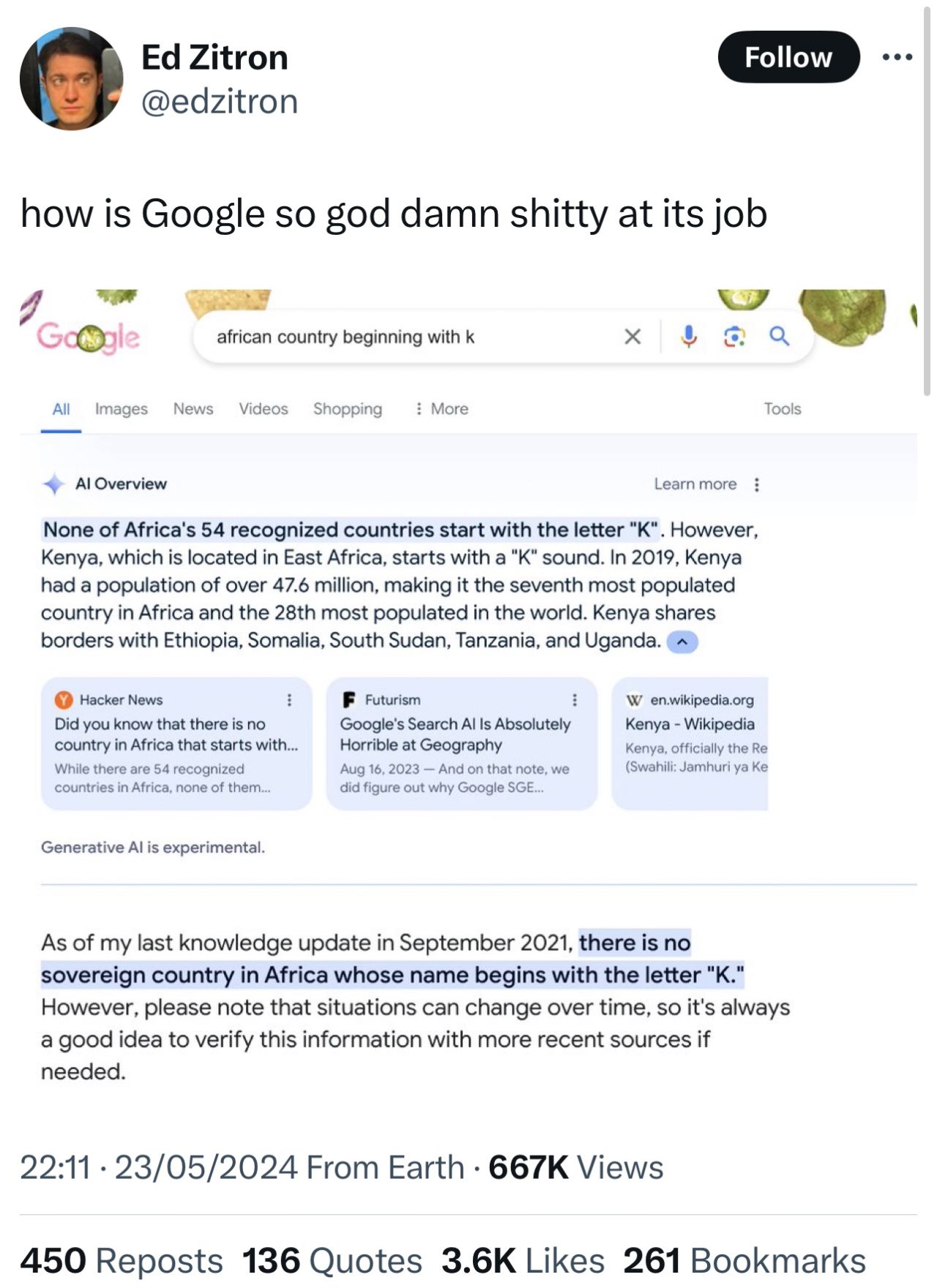

Doch trotz dieses Versprechens zeigt sich erneut, dass KI-Systeme von Natur aus unzuverlässig sind. Nur wenige Tage nach der Einführung in den USA teilten Nutzer Beispiele von Antworten, die bestenfalls seltsam waren. Die KI empfahl, Klebstoff auf Pizza zu geben oder täglich mindestens einen kleinen Stein zu essen. Außerdem behauptete sie, dass der frühere US-Präsident Andrew Johnson zwischen 1947 und 2012 Universitätsabschlüsse erworben habe, obwohl er 1875 starb.

Hier sind noch weitere „AI Summary Fails“, die ich in den letzten Tagen gesammelt habe:

Liz Reid, Leiterin der Google-Suche, gab an, dass Google technische Verbesserungen am System vornimmt, um die Wahrscheinlichkeit falscher Antworten zu verringern. Dazu gehören bessere Erkennungsmechanismen für unsinnige Anfragen und die Einschränkung satirischer, humorvoller und benutzergenerierter Inhalte in den Antworten.

Funktionsweise von „AI Overviews“

Um zu verstehen, warum die KI Fehler macht, muss man sich ansehen, wie sie optimiert wurde. AI Overviews verwendet ein neues generatives KI-Modell aus der Gemini-Familie von Google, das speziell für die Google-Suche angepasst wurde. Dieses Modell wurde in die Kern-Web-Ranking-Systeme von Google integriert, um relevante Ergebnisse aus dem Index der Websites herauszuziehen.

Schwächen des Systems

Große Sprachmodelle sagen einfach das nächste Wort in einer Sequenz voraus, was zu flüssiger Sprache führt, aber auch dazu, dass sie Dinge erfinden. Es wird vermutet, dass das Gemini-Modell in AI Overviews eine Technik namens Retrieval-Augmented Generation (RAG) verwendet, die es ermöglicht, spezifische Quellen außerhalb der Trainingsdaten zu überprüfen.

Dennoch ist RAG nicht narrensicher. Eine schlechte Antwort kann entstehen, wenn entweder der Abruf der Informationen oder die Generierung der Antwort fehlschlägt. So führte die Empfehlung, Klebstoff auf Pizza zu geben, auf einen Scherzbeitrag auf Reddit zurück. Das System erkannte den Beitrag als relevant für die Anfrage, hinterfragte jedoch nicht dessen Richtigkeit oder Intention.

Das System rechnet also derzeit einfach nicht mit Sarkasmus oder Ironie!

Fehlinformationen aus korrekten Quellen

Doch AI Overviews kann auch Fehlinformationen aus faktisch korrekten Quellen generieren. Ein Beispiel ist die Behauptung, dass Barack Obama ein muslimischer Präsident der USA sei, was auf einem Kapitel eines Buches beruhte, das jedoch eine andere Aussageabsicht hatte.

Lösungsansätze und Einschränkungen

Google plant, die Funktion weiter zu verbessern, aber die Unzuverlässigkeit von KI-Systemen bleibt bestehen. Google hat Trigger-Beschränkungen für bestimmte Anfragen eingeführt und zusätzliche Verfeinerungen für gesundheitsbezogene Anfragen vorgenommen. Techniken wie Reinforcement Learning aus menschlichem Feedback können helfen, die Qualität der Antworten zu verbessern. Außerdem könnten Sprachmodelle darin trainiert werden, zu erkennen, wann eine Frage nicht beantwortet werden kann.

Google reagiert auf Kritik an AI Overviews

In einem Beitrag auf der Google-Blogseite reagierte Liz Reid, Vizepräsidentin und Leiterin der Google-Suche, auf die jüngsten Fehlfunktionen der neuen KI-gestützten Suchfunktion AI Overviews. Der Beitrag erklärt ebenfalls, wie „AI Overviews“ funktioniert, welche Fehler aufgetreten sind und welche Maßnahmen Google ergriffen hat, um die Probleme zu beheben.

Liz Reid berichtet, dass Google AI Overviews vor einigen Wochen in den USA eingeführt hat. Laut Nutzerfeedback sind die Suchergebnisse mit AI Overviews zufriedenstellender, und die Nutzer stellen längere und komplexere Fragen. AI Overviews dient als Ausgangspunkt, um zu weiterführenden Webseiten zu gelangen, was zu qualitativ hochwertigeren Klicks führt. Die Nutzer verweilen angeblich länger auf diesen Seiten, da Google bessere Informationen und hilfreiche Webseiten findet.

Liz Reid erklärt darin auch die Funktionsweise von AI Overviews im Detail. Hier sind die wichtigsten Punkte:

- Integration mit Web-Ranking-Systemen: AI Overviews ist in Googles Kern-Web-Ranking-Systeme integriert und soll traditionelle Suchaufgaben erfüllen, wie das Identifizieren relevanter, hochwertiger Ergebnisse aus dem Google-Index.

- Unterschied zu Chatbots: Im Gegensatz zu Chatbots und anderen großen Sprachmodellen (LLMs), die lediglich basierend auf Trainingsdaten Ausgaben generieren, kombiniert AI Overviews die Fähigkeiten eines maßgeschneiderten Sprachmodells mit Googles Suchtechnologie. Es geht nicht nur darum, Text auszugeben, sondern auch relevante Links bereitzustellen, damit Nutzer weiter recherchieren können.

- Genauigkeit und Quellenangaben: AI Overviews ist darauf ausgelegt, nur Informationen anzuzeigen, die durch die besten Web-Ergebnisse gestützt werden. Dies reduziert das Risiko von „Halluzinationen“ oder erfundenen Inhalten, die bei anderen LLM-Produkten häufig auftreten.

- Fehlinterpretationen: Wenn AI Overviews Fehler macht, liegt dies oft an der falschen Interpretation von Anfragen oder sprachlichen Nuancen auf Webseiten oder an einem Mangel an qualitativ hochwertigen Informationen zu einem bestimmten Thema. Diese Herausforderungen treten auch bei anderen Suchfunktionen auf.

Reid betont, dass AI Overviews sich kontinuierlich weiterentwickelt und verbessert, basierend auf Nutzungsdaten und Feedback, um eine qualitativ hochwertige Sucherfahrung zu bieten.

Umgang mit Kritik

Reid geht auf die in den sozialen Medien geteilten seltsamen und fehlerhaften Überblicke ein und betont, dass einige dieser Screenshots gefälscht waren. Google nimmt das Feedback ernst und erklärt, dass man sich bemühe, immer genaue Informationen zu liefern. Einige Fehler resultierten aus der falschen Interpretation von Anfragen oder sprachlichen Nuancen im Web. AI Overviews wurde daraufhin so optimiert, dass nur Informationen angezeigt werden, die durch die besten Web-Ergebnisse gestützt werden.

Verbesserungen und Maßnahmen

Google hat umfassende Tests und Evaluierungen durchgeführt, bevor AI Overviews gestartet wurde. Dennoch traten einige ungenaue oder unhilfreiche Überblicke auf, insbesondere bei ungewöhnlichen Anfragen. Google identifizierte Bereiche, in denen Verbesserungen notwendig waren, wie die Fähigkeit, unsinnige Anfragen und satirische Inhalte zu interpretieren.

- Tests und Evaluierungen: Vor dem Start wurde AI Overviews umfangreich getestet, einschließlich Red-Team-Tests und Bewertungen mit typischen Benutzeranfragen.

- Nutzerfeedback: Millionen von Nutzern stellen neuartige Anfragen, die in Tests nicht abgedeckt werden konnten. Das Feedback hilft, Muster zu erkennen und das System zu verbessern.

- Technische Verbesserungen: Mehrere technische Verbesserungen wurden vorgenommen, darunter bessere Erkennungsmechanismen für unsinnige Anfragen, Einschränkungen für satirische und humorvolle Inhalte sowie die Begrenzung von benutzergenerierten Inhalten in den Antworten.

Besonderheiten und Einschränkungen

- Nicht für alle Themen geeignet: AI Overviews wird nicht für explizite oder gefährliche Themen angezeigt, und es gibt starke Schutzmaßnahmen für Nachrichten- und Gesundheitsthemen.

- Fortlaufende Überwachung und Anpassung: Google überwacht kontinuierlich das System und nimmt bei Bedarf Anpassungen vor, um die Genauigkeit und Zuverlässigkeit von AI Overviews zu gewährleisten.

Google bleibt angeblich also wachsam und überwacht kontinuierlich das Feedback und externe Berichte, um Maßnahmen bei Verstößen gegen Inhaltsrichtlinien zu ergreifen. Liz Reid betont, dass es bei Milliarden von täglichen Anfragen immer zu Fehlern kommen kann, aber Google lerne kontinuierlich aus diesen Fehlern, um die Sucherfahrung für alle zu verbessern.

Letztendlich sollte Google wahrscheinlich klarer machen, dass die Funktion experimentell ist und sich in der Beta-Phase befindet. Sie sollte aus meiner Sicht optional bleiben, bis sie ausgereift ist.

Abonniere das kostenlose KI-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen aus den Bereichen Künstliche Intelligenz für dein Online Business, WordPress, SEO, Online-Marketing und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.