Warum die aktuellen Entwicklungen mehr sind als nur bessere Chatbots – und was das für dich bedeutet

Wenn du in den letzten Wochen das Gefühl hattest, dass in der KI-Welt gerade etwas Grundlegendes passiert, dann liegst du richtig. 2025 ist nicht das Jahr, in dem KI besser reden lernte – es ist das Jahr, in dem sie endlich das Handeln lernt.

Ich selbst arbeite gerade intensiv mit Manus.ai und hatte kürzlich einen echten Durchbruch beim Programmieren mit Claude. Plötzlich konnte ich komplexe Projekte über das Kontextfenster hinaus erweitern und weiterentwickeln, ohne dass das Modell ständig alles zerstört oder anfängt, sich zu wiederholen. Das hat mich dazu gebracht, tiefer zu graben: Was passiert hier eigentlich gerade?

Die Antwort ist faszinierend – und gleichzeitig frustrierend komplex. Deshalb dieser Beitrag: Ich möchte dir zeigen, was sich 2025 wirklich verändert hat und warum die meisten Artikel das Thema nur an der Oberfläche kratzen.

Vom Chatbot zum Agenten: Ein fundamentaler Wandel

Erinnere dich an ChatGPT Ende 2022. Du gibst einen Prompt ein, das Modell antwortet, und dann… wartet es. Du musst den nächsten Schritt machen. Du bist derjenige, der den Prozess steuert.

Das ändert sich jetzt radikal. Die neue Generation von KI-Tools arbeitet nicht mehr nur mit dir, sondern für dich. Der Unterschied ist subtil, aber enorm:

- Chatbot (alt): „Suche nach Wohnungen in Prag unter 1.500€“

→ Du bekommst Vorschläge, musst aber selbst klicken, filtern, Kontakte raussuchen - Agent (neu): „Finde alle Zwei-Zimmer-Wohnungen in Prag unter 1.500€, prüfe die Nähe zum ÖPNV und stelle die Vermieter-Kontakte zusammen“

→ Du schließt den Browser. 20 Minuten später hast du eine fertige Liste.

Theoretisch könntest Du den Agenten sogar anweisen die Wohnungen für dich anzufragen.

Das ist nicht nur praktischer – es ist eine völlig andere Art, wie wir mit Computern arbeiten.

Manus.ai: Mein digitaler Praktikant (mit Macken)

Ich nutze derzeit Manus.ai intensiv, und es ist… kompliziert. Manus ist wie ein hochmotivierter Praktikant: unfassbar fleißig, arbeitet selbstständig, aber manchmal bleibt er auch einfach in der Tür stecken.

Was Manus kann (und was mich begeistert)

Das Versprechen von Manus ist simpel: Du gibst eine Aufgabe, schließt den Browser, und der Agent arbeitet im Hintergrund. Asynchron. Autonom. Das funktioniert verblüffend gut für Dinge wie:

- Marktforschung: „Finde mir alle Startups in Berlin, die im Bereich KI-Sicherheit arbeiten“

- Daten sammeln: „Liste alle Preise von Konkurrenzprodukten auf“

- Lead-Generierung: „Finde Journalisten, die über Klimatechnologie schreiben“

Für solche strukturierten, aber zeitaufwendigen Aufgaben ist Manus Gold wert.

Wo Manus scheitert (und warum das wichtig ist)

Aber: Das moderne Web hasst Bots. Und Manus läuft ständig gegen Wände:

Das CAPTCHA-Problem: Manus kommt nicht durch Cloudflare-Schutz. Es stolpert über Paywalls. Wenn LinkedIn oder eine Datenbank eine Anmeldung verlangt, ist Schluss. Der Agent steht da wie jemand ohne Ausweis vor dem Club.

Das Gedächtnis-Problem: Bei komplexen Aufgaben (z.B. eine Reise planen, die 50 Websites involviert) „vergisst“ Manus, was es am Anfang gemacht hat. Das Kontextfenster füllt sich mit Datenmüll – Navigation, Werbung, Footer – bis das System abstürzt oder in Schleifen gerät.

Um das Problem zu umgehen fragt Manus mittlerweile zwar häufiger, ob es nur einen Teil der Aufgabe erledigen soll, aber das löst die gewünschte Aufgabe dann meist nur sehr oberflächlich oder eben nicht vollständig.

Das Kreativitäts-Problem: Manus ist ein Jäger, kein Schreiber. Es kann brillant Daten finden, aber wenn du erwartest, dass es daraus einen guten Text macht, wirst du enttäuscht. Dafür ist es nicht gebaut.

Das Kosten-Problem: Manus arbeitet mit Credits. Eine komplexe Aufgabe kann 10-20 Credits kosten. Scheitert sie (z.B. wegen eines CAPTCHAs), sind die Credits oft trotzdem weg. Das macht die Planung schwierig.

Mein Workflow mit Manus

Ich habe gelernt: Nutze Manus für das, was es kann. Mein Workflow sieht jetzt so aus:

- Manus: „Finde mir 10 relevante Artikel/Bibliotheken/Quellen zu X“

- Ich: Exportiere die URLs

- Claude: Verarbeitet den Content und macht was Sinnvolles daraus

Manus ist der Retriever. Claude ist der Analyst und Texter. Zusammen sind sie unschlagbar.

Der Claude-Durchbruch: Wenn Gedächtnis billig wird

Jetzt zum aufregenden Teil – und dem Grund für meinen persönlichen „Aha!“-Moment.

Das Problem, das wir alle hatten

Stell dir vor, du arbeitest mit Claude an einer großen Codebasis. Jedes Mal, wenn du eine Frage stellst, muss Claude die GESAMTE Codebasis neu lesen:

- 100.000 Zeilen Code

- 10-15 Sekunden Wartezeit

- Kosten pro Anfrage: 100.000 Tokens Input

Das war teuer und langsam. Niemand konnte so produktiv arbeiten.

Die Lösung: Prompt Caching

Anthropic hat 2025 etwas Geniales eingeführt: Prompt Caching. Die Idee ist simpel, aber revolutionär:

Beim ersten Mal liest Claude deine Codebasis (oder dein 200-seitiges Handbuch) komplett. Das dauert 20 Sekunden und kostet etwas mehr. Aber dann wird dieser Zustand gecacht – im Hochgeschwindigkeits-Speicher gespeichert.

Jede weitere Anfrage:

- Dauert nur noch 2 Sekunden (85% schneller!)

- Kostet 90% weniger (Cache Read statt normaler Input)

Das klingt technisch, aber das Ergebnis ist magisch: Claude fühlt sich plötzlich an wie ein Teamkollege, der alles über dein Projekt weiß und sofort reagiert.

Mein Durchbruch

Das war der Moment, in dem ich es kapiert habe. Ich konnte plötzlich:

- Komplexe Projekte iterativ erweitern, ohne dass Claude den Kontext verliert

- Über Tage hinweg am selben Projekt arbeiten, ohne alles neu hochladen zu müssen

- Keine Redundanzen mehr, weil Claude sich erinnert, was schon existiert

- Keine kaputten Refactorings mehr, weil das Kontextfenster überläuft

Claude Projects macht das noch einfacher: Du lädst deine Codebasis, Dokumentation und Style-Guides in ein „Projekt“ hoch. Claude cacht das automatisch. Du kannst es mit deinem Team teilen. Es ist wie ein gemeinsames Gehirn für euer Projekt.

Das Model Context Protocol (MCP): Der USB-C-Moment

Noch ein technisches Detail, das wichtig ist: MCP ist ein neuer Standard, der Claude mit deinen lokalen Tools verbindet.

Früher: Wenn du wolltest, dass Claude auf deine Datenbank zugreift, musstest du manuell Integrations-Code schreiben.

Jetzt: MCP ist wie ein USB-C-Port. Du startest einen MCP Server (z.B. für deine SQLite-Datenbank), und Claude verbindet sich damit.

Das bedeutet: Claude kann jetzt nicht nur Code schreiben, sondern auch:

- Ihn ausführen

- Die Ausgabe lesen

- Fehler fixen

- Und das Ganze iterieren

Das schließt die Schleife zwischen „Code schreiben“ und „Code testen“ – ein echter Game-Changer.

OpenAI und Google: Die Denker

Während Manus und Claude sich auf Aktion konzentrieren, gehen OpenAI und Google einen anderen Weg: Reasoning.

OpenAI GPT-5.1: Instant vs. Thinking

OpenAI hat sein Modell in zwei Modi aufgeteilt:

- Instant Mode: Schnell, warm, kreativ. Für Gespräche und kreative Arbeit.

- Thinking Mode: Langsam, aber präzise. Pausiert, reflektiert, denkt nach – wie ein Mensch, der ein schwieriges Problem löst.

Codex-Max, die Coding-Variante, kann jetzt „mehrstündige Agenten-Schleifen“ ausführen. Es kann einen Test laufen lassen, ihn scheitern sehen, den Code fixen, neu testen, einen neuen Bug finden, diesen fixen… stundenlang, ohne abzustürzen.

Die Technik dahinter heißt Compaction: Das Modell fasst seine eigene Historie zusammen, wenn das Kontextfenster voll wird, und behält nur das Wesentliche.

Google Gemini 3 Deep Think: Der Mathematik-Savant

Googles Deep Think brilliert bei „Hard Science“: 93,8% auf PhD-Level-Wissenschaftsfragen, löst ungesehene Probleme der Mathe-Olympiade.

Google nennt es ihr „mächtigstes agentisches + Vibe Coding Modell“. Vibe Coding bedeutet hier: Das Modell versteht die Absicht und den Stil deines Projekts, auch wenn du es nur vage beschreibst und baut das Projekt eigenständig.

Wie du die Tools kombinierst: Eine praktische Strategie

Nach all dem technischen Gerede: Was bedeutet das für dich?

Hier ist mein Framework, basiert auf monatelanger Arbeit mit diesen Tools:

Der Gehirn-Vergleich

| Tool | Stärke | Dein Use Case |

|---|---|---|

| Manus.ai | Web-Autonomie, Daten finden | „Finde mir 10 Artikel über X“ |

| Claude | Kontext-Management, Integration | „Lies diese Docs und implementiere Feature Y“ |

| Codex-Max | Langzeit-Iteration | „Refactorisiere dieses Legacy-Modul über Nacht“ |

| Gemini Deep Think | Algorithmen, Wissenschaft | „Löse dieses mathematische Optimierungsproblem“ |

Warum die meisten Artikel zu kurz greifen

Du hast es wahrscheinlich gemerkt: Die meisten Blog-Posts über KI sind kurz und oberflächlich. Sie behandeln alle diese Tools als „bessere Chatbots“.

Sie sind aber keine Chatbots mehr. Sie sind die Komponenten einer neuen digitalen Belegschaft:

- Manus ist dein Praktikant (eifrig, autonom, bleibt aber manchmal stecken)

- Claude ist dein Chefingenieur (kennt alles, schnell, teuer)

- Codex-Max ist dein Auftragnehmer (arbeitet 24h, bis das Problem gelöst ist)

Die Frage ist nicht mehr „Welcher Chatbot ist besser?“, sondern „Welchen Spezialisten brauche ich für diese Aufgabe?“.

A Propos Spezialist…

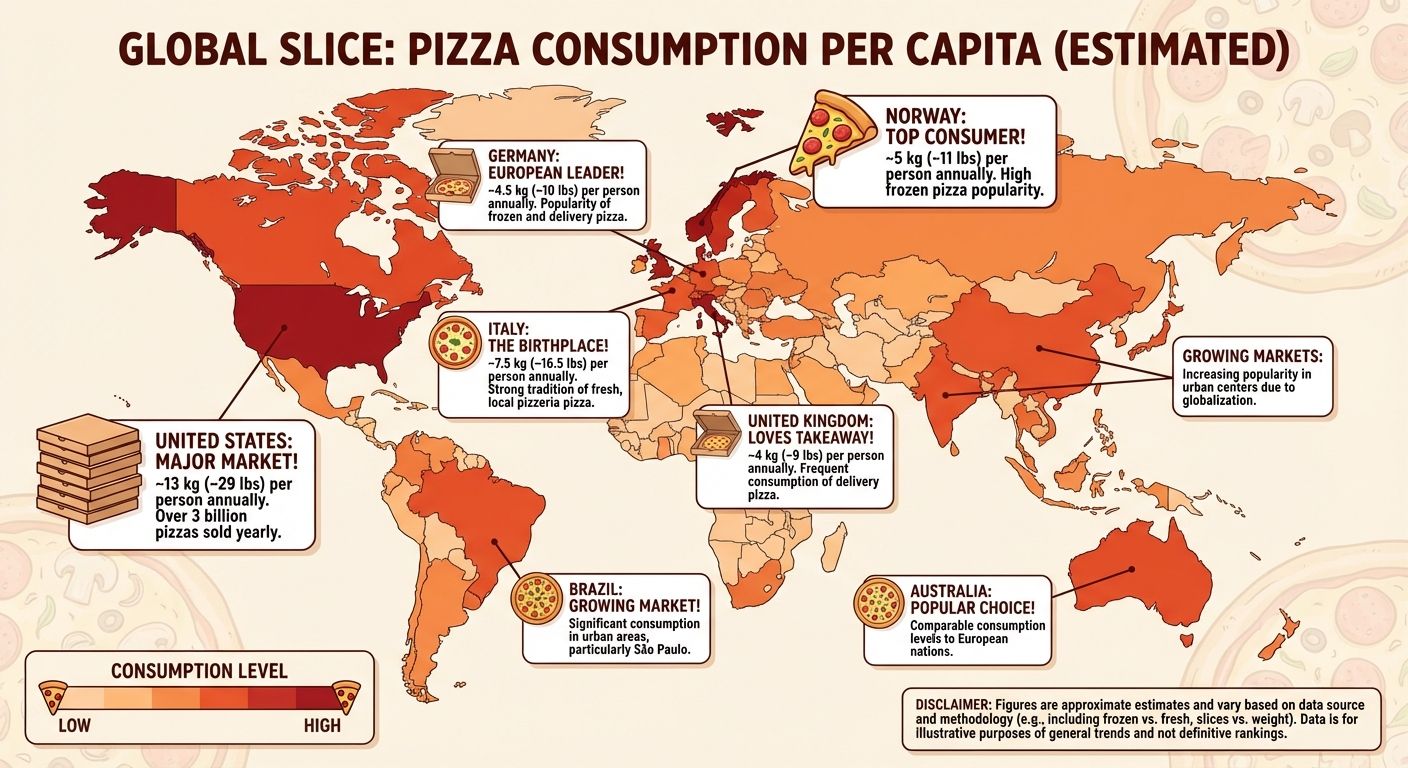

Diese Infografik hat Philipp Schmid, AI Developer Experience bei Google DeepMind und ehemaliger CTO bei HuggingFace mit einem einzigen Prompt und dem neuen Nano Banana Pro (Gemini 3 Pro Image) erstellt:

Für mich das krasseste Beispiel, das ich kürzlich gesehen habe, das zeigt, wie weit Google mit dem agentischen und multimodalen Ansatz schon ist. (Auch wenn sich noch einige Fehler in der Grafik befinden)

Was macht es so besonders? Es kombiniert drei Dinge, die bisher getrennt waren:

- Google Search Grounding: Das Modell kann selbstständig nach Echtzeitdaten suchen

- Reasoning: Es „denkt“ durch den Prompt nach

- High-Fidelity Image Generation: Es erstellt hochauflösende, präzise Visualisierungen

Prompt: Generate an infographic of the pizza per capita.

Das ist alles. Ein Satz. Keine Daten, keine Spezifikationen, keine CSV-Dateien.

Was passiert:

- Das Modell versteht: „Ich brauche Pizza-Konsumptionsdaten pro Land“

- Es sucht selbst nach aktuellen Statistiken über Google Search

- Es entscheidet, wie diese Daten am besten visualisiert werden

- Es erstellt eine komplette, designte Infografik mit korrekten Zahlen, Ländernamen und visuell ansprechender Gestaltung

Das ist nicht „KI macht ein Bild“. Das ist „KI macht Marktforschung, Datenanalyse, Design und Produktion“ – alles in einem Schritt.

Die Kosten? $0.13-0.24 pro Bild (je nach Auflösung). Die Möglichkeiten? Unbegrenzt.

Du gibst einen Satz ein. Das Modell handelt – recherchiert, analysiert, visualisiert. Fertig.

Das ist genau das, was ich mit „2025: Das Jahr, in dem KI das Handeln lernte“ meine.

Warum dieses Beispiel so wichtig ist: Früher hättest du für so eine Infografik gebraucht:

- Eine:n Praktikant:in, der/die Daten recherchiert (Minimum 2 Stunden)

- Eine Excel-Tabelle mit den Zahlen (30 Minuten)

- Eine:n Designer:in, der/die die Grafik erstellt (3-8 Stunden)

- Mehrere Iterationsschleifen für Korrekturen (1-2 Tage)

Jetzt: Ein Satz. 30 Sekunden. $0.13.

Das ist nicht „ein bisschen besser“. Das ist eine andere Realität!

Das Artikelbild ganz oben ist übrigens auch mit Nano Banana Pro entstanden, Input war schlichtweg dieser Beitrag ;o)

Was das für 2026 bedeutet

Die Ära des „All-Zweck-Chatbots“ ist aus meiner Sicht vorbei. Die Zukunft ist Spezialisierung.

Mein persönlicher Durchbruch mit Claude war nicht, dass das Modell schlauer wurde. Es war, dass Gedächtnis billig wurde. Wenn die KI sich an dein Projekt erinnern kann, ohne dass es jedes Mal die Preise einer Transatlantik-Flug kostet, wird sie vom Spielzeug zum Teamkollegen.

Das ist die fundamentale Erkenntnis von 2025.

Zum Schluss

Falls du dich fragst, wo du anfangen sollst:

- Probiere Claude Projects für dein nächstes größeres Projekt aus. Lade Docs hoch, aktiviere Caching. Skills ermöglichen es, für bestimmte Aufgaben spezialisierte Anweisungen zu hinterlegen.

- Experimentiere mit Manus für eine nervige, repetitive Recherche-Aufgabe, die du schon lange aufschiebst.

- Sei geduldig mit den Tools. Sie sind Praktikanten, keine Zauberer. Sie machen Fehler. Aber wenn du ihre Stärken kennst und die Schwächen umgehst, sind sie unglaublich mächtig.

2025 ist nicht das Jahr, in dem KI perfekt wurde. Es ist das Jahr, in dem KI nützlich wurde.

Und dabei habe ich das neue unfassbar

Und das ist vielleicht wichtiger.

Hast du schon Erfahrungen mit KI-Agenten gemacht? Wo sind sie bei dir gescheitert, wo haben sie dich überrascht? Schreib mir – ich bin gespannt auf deine Stories.

Abonniere das AFAIK-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz im Online Marketing!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen Rund um KI aus den Bereichen Online-Marketing, SEO, GEO, WordPress und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.